Aktualisiert

02.05.2012

GRUNDLAGEN

Inhaltsverzeichnis

A) Grundlagen der visuellen IR-Wahrnehmung

B) Optisch-technische Grundlagen

A) Grundlagen der visuellen IR-Wahrnehmung

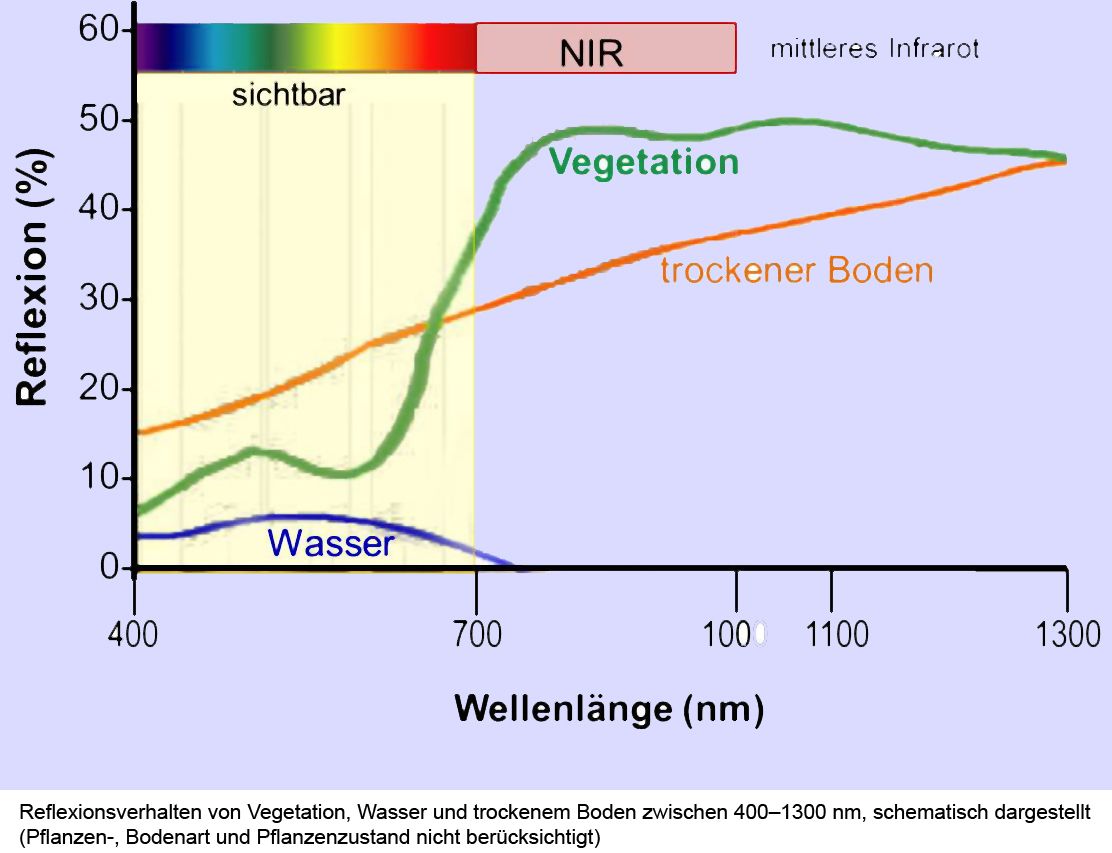

Grundlagen für die visuelle Darstellung des nahen Infrarotbereiches sind neben den technisch-optischen Eigenschaften der Fotoausrüstung (wird nachfolgend beschrieben) das unterschiedliche Reflexionsverhalten von Wasser, Boden und Pflanzen, natürlich auch von Gegenständen, im sichtbaren Spektrum sowie im Nahinfrarotbereich.

Wie in der Abbildung dargestellt, reflektieren Pflanzen im nahen Infrarot

Wie in der Abbildung dargestellt, reflektieren Pflanzen im nahen Infrarot

viel stärker als im sichtbaren Spektrum.

Wasser reflektiert längere Wellen ab 700nm so gut wie gar nicht mehr.

In Infrarot-Landschaftsaufnahmen wird die Vegetation daher hell, Himmel und Wasserflächen dunkel, Wolkenzeichnungen detailliert dargestellt.

Um es an einem Beispiel deutlich zu machen: in Infrarot ist Grün nicht gleich Grün:

Grüne Blätter, pflanzenartbedingt rote Blätter, aber auch nichtgrüne, nicht verholzte Pflanzenteile wie Blattstiele erscheinen kontrastarm und nahezu weiß. Dieses Phänomen wird in der Fotografie als Wood-Effekt bezeichnet.

Es hängt damit zusammen, dass Chlorophyll, aber auch andere (nicht nur pflanzliche) Farbstoffe für Nahes Infrarot quasi durchsichtig sind, es also ohne Absorption und Reflexion passieren lassen.

Bei Blättern wird es von den unteren mit Lufteinschlüssen versehenen Blattschichten (das sogenannte Schwammgewebe) reflektiert – zu sehen bekommen wir praktisch ein schnee-ähnliches Phänomen.

Andere Beispiele: auch Gummibärchen, Getränke, Sonnenbrillen und Kunststoffbestandteile können je nach Zusammensetzung gläsern erscheinen. Menschliche Augen werden heller, die menschliche Haut fast wachsartig.

Zurück zum Anfang

B) Optisch-technische Grundlagen

Grundsätzlich ist bei Digitalkameras die Auflösung eines fotografischen Linsenobjektivs auf Basis der Lichtbrechung und des nachgeschalteten Sensors von mehreren Faktoren abhängig. Ihr Zusammenspiel ist auf eine optimale Darstellung der Informationen des für den Menschen sichtbaren Spektralbereiches von ca. 400 nm bis etwas über 700 nm ausgelegt. Für den oberhalb von 700 nm beginnenden Bereich des optischen Infrarots, zu trennen vom noch längerwelligen thermischen Infrarot, sind daher im Bezug auf Blende, Brennweite, spektrale Korrektur, Pixelgrösse, Kanalverwertung und Auflösung folgende Zusammenhänge besonders zu berücksichtigen:

- Eine längere Brennweite wird Objektstrukturen proportional besser auflösen als eine kurze Brennweite. Anders ausgedrückt bietet ein grösserer Abbildungsmassstab die bessere Objektauflösung.

- Eine grosse Blendenöffnung / kleine Blendenzahl wird Strukturen proportional besser auflösen als eine kleine Blendenöffnung / geringere Lichtstärke, bedingt durch wellenphysikalische Beugungseffekte, die der gewollten Brechung nach den Gesetzen der geometrischen (Strahlen-) Optik entgegenwirken. Dies gilt streng genommen nur für (zweidimensionale) Objekte, die exakt in der Schärfeebene liegen.

- Abbildungen mit einer kurzen Wellenlänge sind umgekehrt proportional schärfer als mit längeren (Schwerpunkts-) Wellenlängen. (Deshalb arbeitet die Mikrolithografie im UV.)

- Zur korrekten Belichtung eines Sensors / einzelnen Pixels ist eine bestimmte Energie nötig. Bei zu geringer Energie ergibt sich ein schlechter Signal / Störabstand, also Rauschen . Die Energie von elektromagnetischer Strahlung ist zudem proportional zum Quadrat der Frequenz, oder umgekehrt proportional zum Quadrat der Wellenlänge. Das längerwellige optische Infrarot ist somit energieärmer als das im Mittel kürzerwellige sichtbare Spektrum oder das noch kurzwelligere Ultraviolett.

- Ein Objektiv kann nur in Wellenlängenbereichen optimal abbilden, für die es bei der Optikberechnung vorgesehen war.

- Wird ein Objektiv in Wellenlängenbereichen benutzt, für die es nicht gerechnet / korrigiert ist, werden Farblängsfehler (das infrarote Bild entsteht z.B. in axialer Richtung hinter dem Bild von z.B. grüner Strahlung) auftreten und zusätzlich noch Farbquerfehler (Ein infrarotes Bild wird in derselben Auffangebene eine andere Grösse haben als z.B. ein grünes Bild, sprich es werden Farbsäume resultieren.)

- Der Farblängsfehler lässt sich in seinen störenden Auswirkungen durch Abblenden verringern, dies kollidiert aber mit Punkt 2).

- Der Farblängsfehler eines Objektives nimmt im Allgemeinen mit seiner Brennweite zu, hier kollidieren die Erwartungen an die Auflösung mit Punkt 1.

- Ein Sensor mit Pixeln kleinerer Grösse / grösserer Pixelzahl kann räumlich höher auflösen als mit geringerer Pixelzahl. Auf einer kleineren Pixeloberfläche können allerdings weniger Photonen eingefangen werden, also weniger Belichtungsenergie pro Pixel wird empfangen. Dies tritt in Wechselwirkung mit Punkt 4).

- Wird mit einer digitalen Kamera und dem üblichen Bayer-RGB -Pattern aufgenommen, fällt der Grossteil der effektiven Infrarot-Belichtung im Rotkanal an. Blau- und Grünkanal des Sensors enthalten aber auch Informationen über die räumliche Struktur des Objektes, d.h. bedeuten Auflösung. Somit hängt die praktische Auflösung davon ab, ob im Wesentlichen nur die roten Pixel (25% der Gesamtzahl) das Bild aufbauen oder alle Pixel (im Verhältnis 1 Rot zu 2 Grün zu 1 Blau) die strukturelle Information über das Objekt tragen und das Bild somit schärfer machen. Da die Belichtung von Grün und Blau schwächer als Rot ist, sinkt dann die gemittelte Belichtungsintensität im Vergleich zur reinen Rotkanalauswertung.

- Durch die Möglichkeiten der Digitaltechnik ist es rechnerisch möglich, die wellenoptischen Beschränkungen für die Auflösung in bestimmten Grenzen zu verringern. Durch geschickt gewählte Unschärfemasken in der Pixelverrechnung / Bildbearbeitung können praktisch verwertbare Auflösungen erzielt werden, die höhere Schärfe liefern als vom konventionell-fotochemischen Film gewohnt. Dabei ist jedoch die Gefahr von Rauschen und Artefakten gegeben. Wo künstliche, willkürliche Bildstrukturen entstehen, kann die gewünschte hohe „echte“ Auflösung überlagert, gestört oder vermindert werden.